Asset-Management-Daten 101

- tggc2021

- 29. Jan. 2025

- 5 Min. Lesezeit

1. Warum sich Vermögensverwalter um ihre Datenarchitektur kümmern sollten

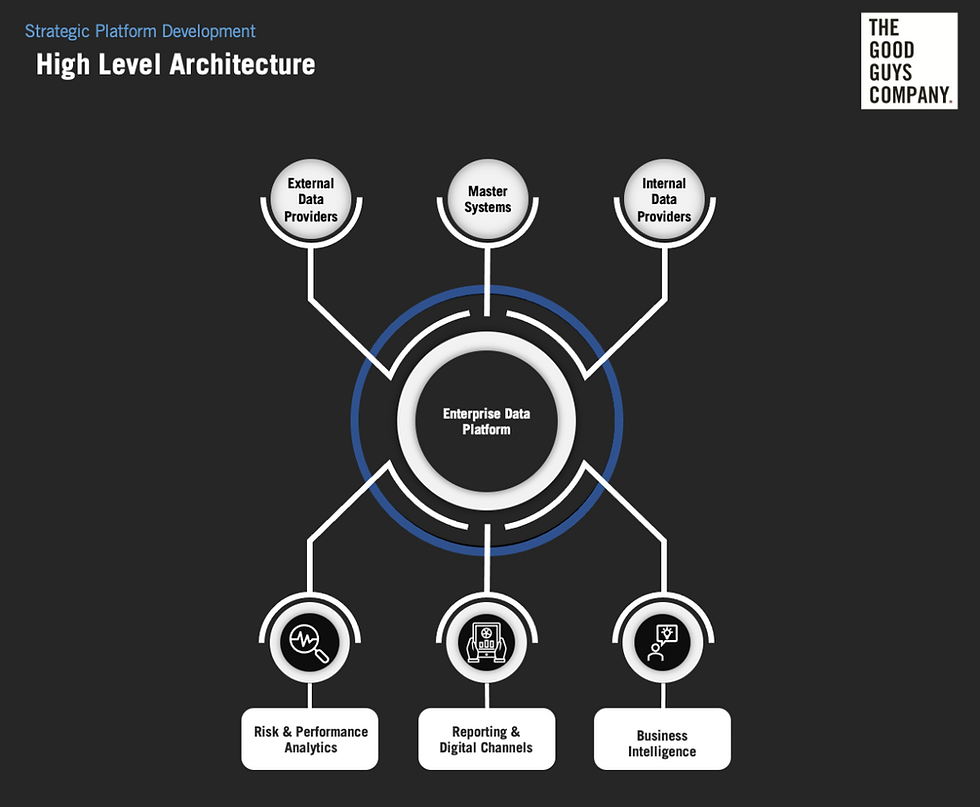

Daten dienen als Input für alle Ihre Geschäftsinformationen. Einst Nischenthemen, ESG- und alternative Daten, Data Mining und Business Intelligence sind wichtig und allgegenwärtig geworden. Unternehmen können jedoch nur dann den Wert von Daten und datengesteuerten Aktivitäten schöpfen, wenn die zugrunde liegende Datenarchitektur für den Zweck geeignet ist. Es ist die Datenarchitektur, die sicherstellt, dass der aktuelle und zukünftige Informationsbedarf skalierbar und qualitativ zufriedenstellend gedeckt werden kann.

Das Verständnis der Datenarchitektur hilft dem Management, sich auf die verschiedenen Bereiche zu konzentrieren, in denen Änderungen erforderlich sind, um seinen Informationsbedarf zu decken. Bei ESG-Daten als prominentes Beispiel liegt die Schwierigkeit weniger in ihrer technischen Bereitstellung, sondern vielmehr in ihrer Qualität, Relevanz, Vergleichbarkeit und Interpretation. Bei Echtzeit-Preis- und Marktexposure-Daten liegt die Komplexität in der Dateninfrastruktur selbst, während bei Business Intelligence die Verfügbarkeit der Daten in einer einzigen zuverlässigen Quelle wahrscheinlich entscheidend ist.

Eine schwache Datenarchitektur erfordert häufig IT-Änderungen am Einstiegspunkt oder an vorgelagerten Systemen der Dateninfrastruktur des Unternehmens, bevor eine neue Geschäfts- oder Endbenutzeranforderung erfüllt werden kann. Umgekehrt stellt eine gute Datenarchitektur sicher, dass Sie sich ohne langwierige IT-Projekte auf die Schaffung von Geschäftswert konzentrieren, schnell neue Produkte auf den Markt bringen und zeitnah auf Kundenanfragen reagieren können.

2. Eine gute Datenarchitektur ist ein Differenzierungsmerkmal, alles selbst zu bauen ist es nicht

Es mag wie ein IT-Thema klingen, das nichts mit dem Verkauf von Produkten oder der Erzielung von Anlagerenditen für Ihre Kunden zu tun hat. Dennoch ist es ein äußerst wichtiger Differenzierungsfaktor, Ihre Datenarchitektur so früh wie möglich richtig zu gestalten. Ohne die erforderlichen Daten wird Ihr Unternehmen keinen Mehrwert gegenüber der Konkurrenz bieten können.

Daten bestimmen jeden Aspekt der Kundenbeziehung und die Wahrnehmung Ihres Vermögensverwalters durch den Kunden. Von der Leistungserbringung durch besser informierte Anlageentscheidungen bis hin zur Bereitstellung hochwertiger Berichte und digitaler Kanäle für Kunden. Schließlich möchten Sie vermeiden, jedes Mal, wenn Sie ein neues Produkt oder eine neue Dienstleistung anbieten möchten, in teure Änderungsprojekte in Ihrer Datenversorgungskette investieren zu müssen. Sie können Ihre Wartungskosten optimieren und so das Budget für Änderungsprojekte freigeben, die direkten Mehrwert schaffen.

3. Datenlieferung und -integration

Zu Beginn der Datenversorgungskette werden extern und intern generierte Daten in eine Landing Zone, einen Data Lake oder direkt in ein strukturiertes Data Warehouse aufgenommen. Dieser klassische ETL-Prozess (Extrahieren, Transformieren, Laden) bzw. Datenintegrationsprozess ist eine große Quelle von IT-Änderungskosten und erfordert Ressourcen, um eine ständige Überwachung der Aktualität und Datenqualität zu gewährleisten. Alle Prozesse müssen zeitlich festgelegt und auf ihre Vollständigkeit überprüft werden.

Hier sind einige Optionen und Möglichkeiten, das oben genannte Problem anzugehen

One-to-One Sourcing, der „klassische“ Weg (zB per FTP/Datei, API)

In dieser Einstellung werden die Daten direkt vom Anbieter bezogen, wobei ein Connector verwendet wird, der den Spezifikationen des Anbieters entspricht.

Diese etwas antiquierte Methode kann immer noch erforderlich sein, wenn Sie kleinere oder Nischenanbieter nutzen, nur wenige spezielle Datenanbieter angebunden werden müssen oder die beteiligten Systeme keine anderen Wege der Datenübertragung zulassen, beispielsweise bei großen Datenmengenabfragen.

Der Einsatz einer Datenintegrationsschicht kann den IT-Aufwand reduzieren und die Datenarchitektur vereinfachen

Die Integrationsschicht bietet einen Punkt für den Zugriff auf Daten in verschiedenen Eingabeformaten und aus verschiedenen Quellen und entkoppelt so die internen Systeme vom ETL-Prozess.

Um die Anzahl der internen Schnittstellen zu reduzieren, kann ein universeller Konnektor von Ihrer Integrationsschicht zu nachgelagerten Systemen verwendet werden.

Wenn keine Datenintegrationsschicht oder kein Datenintegrationsanbieter verwendet wird, erfordern neue Verbindungen einen erheblichen Entwicklungs- und Testaufwand, die Anpassung der Firewall-Einstellungen sowie die Integration in Datenverwaltungs- und Governance-Prozesse.

Zur Beschaffung von Echtzeitdaten, wie etwa Instrumentenpreisen, sind möglicherweise weiterhin Eins-zu-eins-Verbindungen erforderlich, da diese häufig spezifisch für Veranstaltungsorte und Anzeigesysteme sind.

Nutzung von Datenaggregatoren und Cloud-Funktionen

Ein relativ neuer Trend in der Datenlandschaft sind Finanzdatenaggregatoren und -börsen, die unterschiedliche Datentypen von einer großen Vielfalt an Anbietern aus einer einzigen Quelle bereitstellen.

Plattformen wie Crux, Open: Factset, BattleFin, Quandl und Knoema decken ein breites Spektrum an Datensätzen ab, von alternativen Daten bis hin zu Index-Benchmarks, Kreditratings, Börsenkursen und vielen weiteren Quellen.

Daten können entweder direkt vom Datenaustausch empfangen oder über den Datenmarktplatz eines Cloud-Anbieters bestellt werden. AWS und Snowflake bieten beispielsweise Finanzdaten an, die direkt im jeweiligen Data Warehouse verfügbar gemacht werden, sodass Sie keine eigene ETL-Lösung erstellen müssen.

Während Datenempfänger ihre Abonnements häufig direkt beim jeweiligen Datenanbieter verwalten, bieten manche Börsen auch eine E-Commerce-Plattform an, auf der Daten lizenziert werden können, ohne den jeweiligen Datenanbieter direkt kontaktieren zu müssen.

Einige Datenaggregatoren bieten verwaltete Dienste wie Bereitstellungsmanagement über verschiedene unterstützte Konnektoren oder Formate sowie eine Validierung der Datenqualität, bevor die Daten den Client erreichen.

Diese Form der Datenaggregation und -verteilung ist noch ein junges Geschäft. Daher ist es notwendig, auf mögliche Lücken zu achten. Wenn Sie beispielsweise nach einem bestimmten Benchmarkindex suchen, ist dieser möglicherweise noch nicht über eine Datenbörse verfügbar.

Nutzung eines Managed Data Service Providers

Als separate Option mit dem größten Einfluss auf das Betriebsmodell bieten Outsourcing-Anbieter die Bereitstellung der gesamten Datenversorgungskette bis hin zum Betrieb des Data Warehouse an.

Die Wahl der Methode zur Datenübermittlung liegt vollständig in der Verantwortung des Outsourcing-Anbieters.

Eignung des Betriebsmodells, Gesamtkosten und Angebotsumfang sowie Auswirkungen auf die Datenverwaltung und Datenmanagementprozesse müssen im Detail berücksichtigt werden.

Der nächste wichtige Schritt besteht darin, die Definition und Verwendung eines Unternehmensdatenmodells sicherzustellen, das es Ihrem Unternehmen ermöglicht, eine einzige Quelle der Wahrheit zu nutzen. Beispielsweise sollte dieselbe Sicherheit oder Transaktion für alle Benutzer einheitlich definiert sein, sei es Ihr Risikoteam oder Ihre Portfoliomanager. Sie können Ihr eigenes Unternehmensdatenmodell erstellen oder vorhandene für die Branche nutzen, die von einem Dienstanbieter erstellt und gepflegt werden.

Generell empfehlen wir, direkte Verbindungen zu einzelnen Datenanbietern zu vermeiden, es sei denn, es gibt keine praktikablen Alternativen. Die Abhängigkeit von einem Managed Data Service Provider fügt dem internen Datenmanagement neue Überwachungsaufgaben hinzu, entlastet es jedoch oft von vielen manuellen oder Support-bezogenen Aufgaben. Durch sorgfältige Berücksichtigung der Anforderungen kann eine skalierbare Datenarchitektur implementiert werden, die einen Wettbewerbsvorteil auf dem Markt darstellt.

4. Daten-Governance und Datenmanagement

Die Data-Governance-Richtlinie beschreibt die Verantwortlichkeiten von Einzelpersonen und Teams in Bezug auf Dateneigentum, die Verwaltung von Datenzugriffsrechten sowie die Verantwortlichkeiten in Bezug auf klar definierte Datenfunktionen und Datensätze. Eine gute Datenarchitektur ist eine Voraussetzung für die Einführung einer effektiven Data Governance, da sie die notwendige Transparenz und Kategorisierung von Daten und zugehörigen Funktionen bietet. Gleichzeitig ist eine gute Data Governance entscheidend für die Aufrechterhaltung und Konsistenz einer guten Datenarchitektur.

Das Datenmanagement ist eine Geschäftsfunktion, die als zentrale Anlaufstelle für alle datenbezogenen Anfragen dient. Es ist das Team, das für die Sicherstellung der Datenqualität, Aktualität und Konsistenz über alle Systeme hinweg verantwortlich ist. Das Team arbeitet im Rahmen der Datenverwaltung und übernimmt die Verantwortung für bestimmte Datensätze, die den verschiedenen Geschäftsfunktionen zur Verfügung gestellt werden.

Ein Betriebsmodell, das auf internen ETL-Systemen und Batch-Verarbeitung basiert, geht häufig mit einer umfassenden Einbindung des Datenmanagements in die Überwachung und Einmischung in die technische Verarbeitung einher, sowie mit der Notwendigkeit eines IT-Teams, das sie unterstützt. Fragen und Probleme im Zusammenhang mit der Datenqualität und Aktualität aus den verschiedenen Geschäftsbereichen erfordern häufig umfangreiche Untersuchungs- und Lösungsprozesse.

Der Einsatz von Datenaggregatoren oder Managed Service Providern verändert die Arbeitsbeschreibung des Datenmanagementteams. Normalerweise bleiben ihre Verantwortlichkeiten gegenüber internen Geschäftsfunktionen im Rahmen der Datenverwaltung. Die vorgelagerten Verantwortlichkeiten konzentrieren sich jedoch eher auf eine Aufsichtsfunktion. Anstatt direkt in Prozesse eingreifen zu müssen, ist das Datenmanagement dafür verantwortlich, die rechtzeitige Bereitstellung von Daten von einem externen Anbieter innerhalb eines genau definierten SLA zu überwachen. Alle IT-bezogenen Probleme vor dem Data Warehouse des Asset Managers liegen nun in der Verantwortung des Anbieters.

Hat Ihnen dieser Artikel Denkanstöße gegeben? Stehen Sie vor Datenherausforderungen oder denken Sie darüber nach, Ihre Datenarchitektur zu verbessern? Möchten Sie eine skalierbare und solide Datenarchitektur, die Investitionsentscheidungen, hochwertiges Reporting, digitale Vertriebskanäle und Business Intelligence ermöglicht und so Innovationspotenzial freisetzt? Lassen Sie uns besprechen, wie wir Ihnen helfen können.

Kommentare